Professional Machine Learning Engineer

あなたのチームは、畳み込みニューラルネットワーク(CNN)ベースのアーキテクチャをゼロから構築しています。オンプレミスのCPUのみのインフラストラクチャで実行した初期実験は有望でしたが、収束が遅いという課題があります。市場投入までの時間を短縮するために、モデルトレーニングを高速化するよう依頼されました。より強力なハードウェアを活用するために、Google Cloud上の仮想マシン(VM)で実験したいと考えています。あなたのコードには手動のデバイス配置は含まれておらず、Estimatorモデルレベルの抽象化でラップされていません。どの環境でモデルをトレーニングすべきですか?

あなたは、全員がAI Platformを使用する50人以上のデータサイエンティストからなる成長中のチームで働いています。ジョブ、モデル、バージョンを整理されたスケーラブルな方法で管理するための戦略を設計しています。どの戦略を選択すべきですか?

あなたはトレーニング時間を短縮してセマンティック画像セグメンテーションのためのディープラーニングモデルをトレーニングしています。Deep Learning VM イメージを使用中に、次のエラーが発生しました: リソース 'projects/deeplearning-platforn/zones/europe-west4-c/acceleratorTypes/nvidia-tesla-k80' が見つかりませんでした。どうすればよいですか?

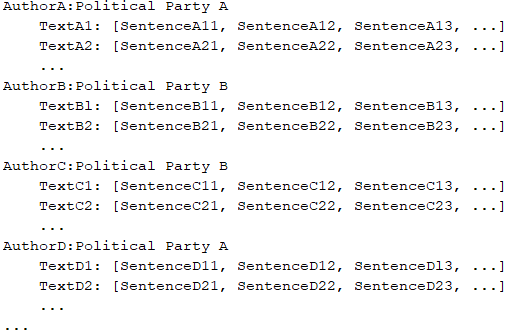

あなたのチームは、著者が書いた記事に基づいて著者の政治的所属を予測するNLPリサーチプロジェクトに取り組んでいます。大規模な訓練データセットがあり、その構造は次のようになっています。 訓練、テスト、評価のサブセット間で標準的な80%-10%-10%のデータ分布に従いました。80-10-10の割合を維持しながら、訓練例を訓練・テスト・評価サブセットにどのように分配すべきですか?

あなたのチームは、プラットフォームの1つのサポートリクエストを分類するために、Google CloudでMLソリューションを作成するタスクを任されました。要件を分析した結果、モデルのコード、サービング、デプロイメントを完全に制御できるように、TensorFlowを使用して分類器を構築することにしました。MLプラットフォームにはKubeflowパイプラインを使用します。時間を節約するために、完全に新しいモデルを構築する代わりに、既存のリソースを活用し、マネージドサービスを使用したいと考えています。分類器をどのように構築すべきですか?