Professional Machine Learning Engineer

あなたはResNet50アーキテクチャに基づいたPyTorchを使用して画像認識モデルを開発しています。あなたのコードは、ローカルのラップトップ上の小さなサブサンプルでは正常に動作しています。完全なデータセットには20万枚のラベル付き画像があります。トレーニングワークロードを迅速に拡張し、コストを最小限に抑えたいと考えています。4つのV100 GPUを使用する予定です。何をすべきですか?

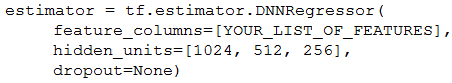

あなたは、一連の予測特徴量を使用して住宅価格を予測するために、TensorFlowでDNNリグレッサーを訓練しました。デフォルトの浮動小数点精度はtf.float64で、標準のTensorFlow Estimatorを使用しています。 (画像参照: estimator = tf.estimator.DNNRegressor( feature_columns=[YOUR_LIST_OF_FEATURES], hidden_units=[1024, 512, 256], dropout=None) ) モデルの性能は良好ですが、本番環境にデプロイする直前に、現在のサービングレイテンシが90パーセンタイルで10ミリ秒であり、現在CPUでサービングしていることがわかりました。本番環境の要件では、90パーセンタイルで8ミリ秒のモデルレイテンシが求められています。レイテンシ要件を満たすためであれば、わずかな性能低下は許容できます。 したがって、あなたの計画は、モデルの予測がどの程度低下するかを評価しながら、レイテンシを改善することです。サービングレイテンシを迅速に低下させるために、最初に何を試すべきですか?

あなたは製造会社のデータサイエンスチームで働いています。あなたは、数億件のレコードを持つ会社の過去の販売データをレビューしています。探索的データ分析のために、平均、中央値、最頻値などの記述統計量を計算し、仮説検定のための複雑な統計的検定を実施し、特徴量の経時的な変動をプロットする必要があります。計算リソースを最小限に抑えながら、分析にできるだけ多くの販売データを使用したいと考えています。あなたは何をすべきですか?

あなたのデータサイエンスチームは、様々な特徴量、モデルアーキテクチャ、ハイパーパラメータを用いて迅速に実験を行う必要があります。彼らは様々な実験の精度メトリクスを追跡し、APIを使用して時系列でメトリクスを照会する必要があります。手作業を最小限に抑えながら実験を追跡し報告するためには、何を使用すべきでしょうか?

あなたは、個人識別情報(PII)と見なされるいくつかの値を含むBigQueryに保存されたデータを使用してMLモデルをトレーニングしています。モデルをトレーニングする前に、データセットの機密性を低減する必要があります。すべての列がモデルにとって重要です。どのように進めるべきですか?